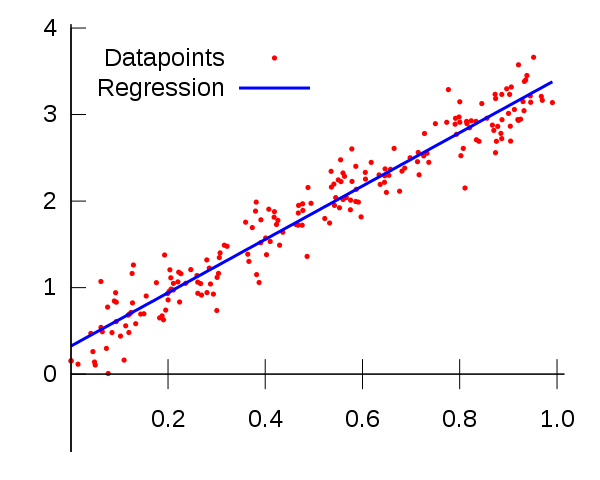

Was ist der lineare Regressions-MT4-Indikator?

Die lineare Regression war die erste Art der Regressionsanalyse, die eingehend untersucht und umfassend in praktischen Anwendungen eingesetzt wurde. Dies liegt daran, dass Modelle, die linear von ihren unbekannten Parametern abhängen, einfacher anzupassen sind als Modelle, die nicht linear von ihren Parametern abhängen, und weil die statistischen Eigenschaften der resultierenden Schätzung unterschiedlich sind rs sind einfacher zu bestimmen.

In der Statistik ist die lineare Regression ein linearer Ansatz zur Modellierung der Beziehung zwischen einer skalaren abhängigen Variablen y und einer oder mehreren erklärenden Variablen (oder unabhängigen Variablen) mit der Bezeichnung X. Der Fall einer erklärenden Variablen ist Dies wird als einfache lineare Regression bezeichnet. Für mehr als eine erklärende Variable spricht man von multipler linearer Regression. (Dieser Begriff unterscheidet sich von der multivariaten linearen Regression, bei der mehrere korrelierte abhängige Variablen vorhergesagt werden und nicht eine einzelne skalare Variable.)

Bei der linearen Regression werden die Beziehungen mithilfe linearer Prädiktorfunktionen modelliert, deren unbekannte Modellparameter aus den Daten geschätzt werden. Solche Modelle werden lineare Modelle genannt. Am häufigsten wird angenommen, dass der bedingte Mittelwert von y bei gegebenem Wert von X eine affine Funktion von X ist; Seltener wird der Median oder ein anderes Quantil der bedingten Verteilung von y bei gegebenem X als lineare Funktion von X ausgedrückt. Wie alle Formen der Regressionsanalyse auch lineare Regression ion konzentriert sich auf die bedingte Wahrscheinlichkeitsverteilung von y bei gegebenem X und nicht auf die gemeinsame Wahrscheinlichkeitsverteilung von y und X, die den Bereich der multivariaten Analyse darstellt.

Die lineare Regression hat viele praktische Anwendungen. Die meisten Anwendungen fallen in eine der folgenden zwei großen Kategorien:

Wenn das Ziel eine Vorhersage oder Fehlerreduzierung ist, kann die lineare Regression verwendet werden, um ein Vorhersagemodell an einen beobachteten Datensatz mit Y- und X-Werten anzupassen. Wenn nach der Entwicklung eines solchen Modells ein zusätzlicher Wert von

Wenn eine Variable y und eine Anzahl von Variablen X1, …, zwischen y und dem Xj, um zu beurteilen, welches Xj möglicherweise keine Beziehung zu y hat überhaupt, und um zu identifizieren, welche Teilmengen des Xj redundante Informationen über y enthalten.

Lineare Regressionsmodelle werden häufig mithilfe des Ansatzes der kleinsten Quadrate angepasst, sie können jedoch auch auf andere Weise angepasst werden, beispielsweise durch Minimierung des „Mangels an Anpassung“ in einer anderen Norm (z. B. bei der Regression der kleinsten absoluten Abweichungen). on), oder durch Minimierung einer Strafe Die Version der geringsten Abweichungen verliert ihre Funktion wie bei der Ridge-Regression (L2-Norm-Methode) und dem Lasso (L1-Norm-Methode). Umgekehrt kann der Ansatz der geringsten Abweichungen verwendet werden, um Modelle anzupassen, die keine linearen Modelle sind. Obwohl die Begriffe „kleinste Quadrate“ und „lineares Modell“ eng miteinander verbunden sind, sind sie nicht gleichbedeutend.